La loi européenne sur l’IA est entrée en vigueur ! Voici ce qu’il faut savoir.

La loi européenne sur l'IA est entrée en vigueur ! Découvrez dans ce nouvelle article tout ce qu'il faut savoir.

Après de longues négociations et discussions entre les institutions et organes européens, une loi sur l’IA est entrée en vigueur le 1er août 2024, appelée EU AI Act ou loi européenne sur l’intelligence artificielle.

Si l’intelligence artificielle offre un vaste potentiel et des opportunités commerciales, les implications éthiques et les risques inhérents à l’IA signifient qu’elle doit être utilisée de manière responsable et avec modération. L’EU AI Act établit des lignes directrices claires pour garantir que les entreprises appliquent cette technologie naissante de manière appropriée et éviter les complications à long terme.

Comprendre la loi européenne sur l’IA en 5 étapes

-

L’objectif de la loi sur l’IA

La loi européenne sur l’IA est la première réglementation globale au monde sur l’intelligence artificielle, conçue pour prévenir et atténuer les risques potentiels en matière d’éthique et de sécurité en fonction de leur gravité. L’objectif est de garantir que les systèmes d’IA sont sûrs, dignes de confiance et qu’ils respectent les droits fondamentaux.

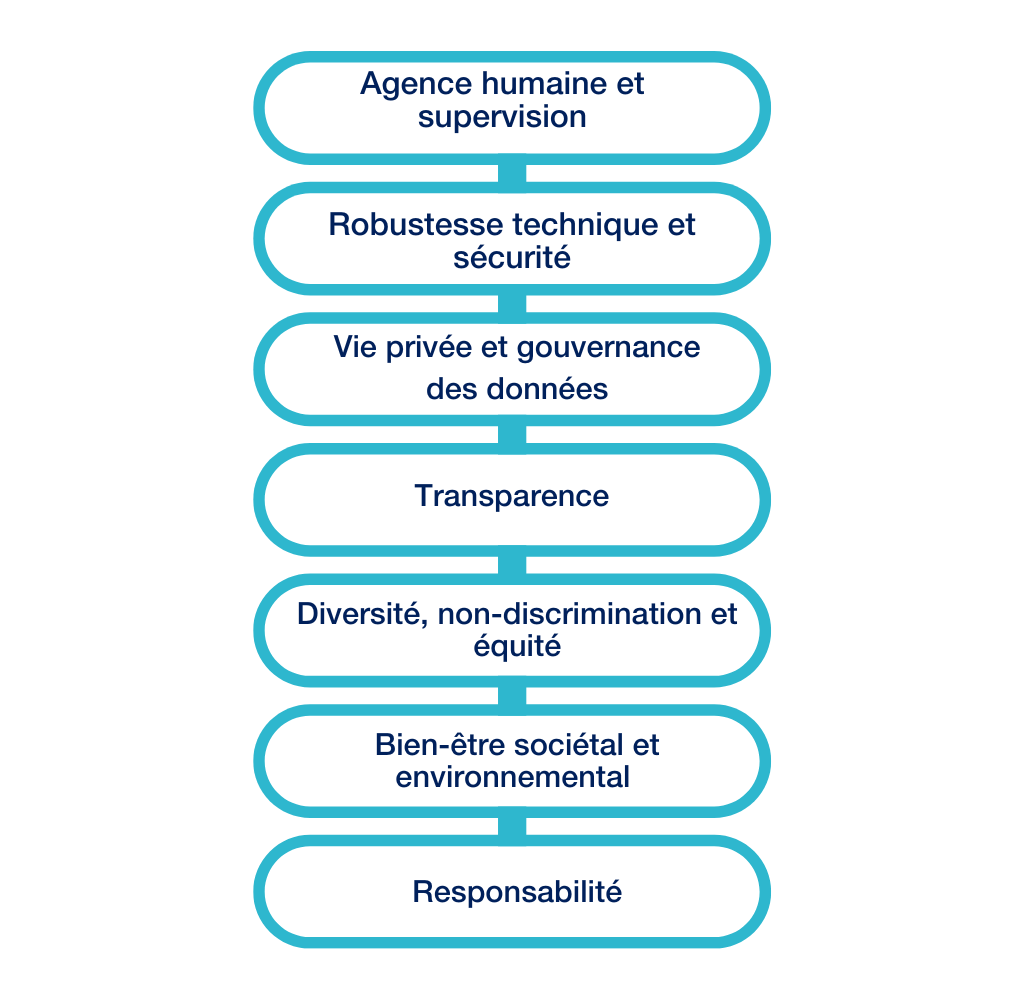

La réglementation s’appuie sur sept principes fondamentaux établis par le groupe d’experts de haut niveau (HLEG) et les traduit en obligations concrètes afin d’unifier l’approche de la gouvernance de l’IA dans l’ensemble de l’UE. Les principales exigences sont les suivantes :

Bien qu’il s’agisse d’un règlement de l’UE, la loi européenne sur l’IA a une application extraterritoriale. Si elle s’applique aux systèmes d’IA développés et utilisés sur le marché européen, elle s’applique également aux entités non européennes si leurs systèmes d’IA ont un impact sur les citoyens européens. Il existe toutefois des exemptions spécifiques, telles que la recherche et le développement sans déploiement ou mise sur le marché, les fins militaires ou l’utilisation personnelle.

Mais comment définir un « système d’IA » ? La réglementation nous donne une définition précise, mais très large, composée de trois critères cumulatifs :

- Autonomie: un système basé sur une machine qui est conçu pour fonctionner avec différents niveaux d’autonomie et qui peut faire preuve d’adaptabilité après son déploiement.

- Génération de résultats: traite les données d’entrée pour produire une série de résultats, y compris des prédictions, du contenu, des recommandations ou des décisions, par le biais de commandes explicites ou d’objectifs déduits.

- Influence: les résultats peuvent influencer des environnements physiques ou virtuels.

-

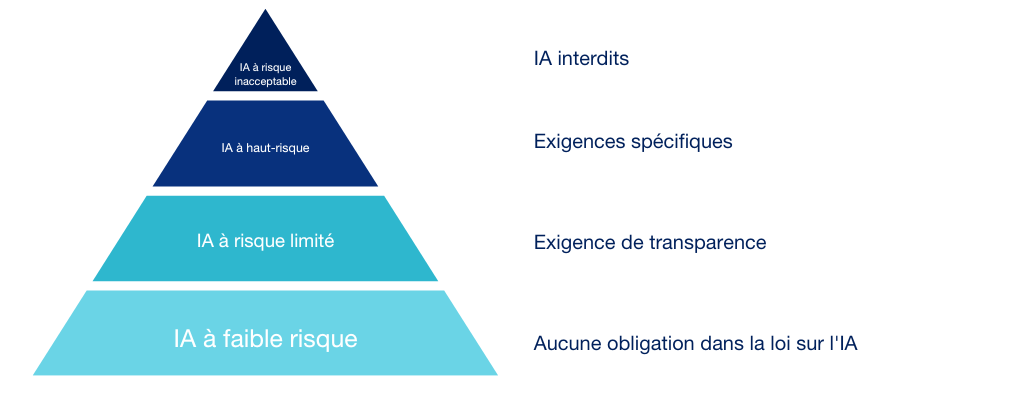

Catégorisation en fonction de la gravité du risque

Les systèmes d’IA sont classés à différents niveaux en fonction des risques potentiels qu’ils peuvent présenter pour la santé, la sécurité et les droits fondamentaux. Les catégories sont les suivantes :

Systèmes d’IA à risque inacceptable

Certains systèmes d’IA sont considérés comme présentant un risque inacceptable pour la sécurité et les droits fondamentaux des personnes. Afin d’éviter les abus et de préserver la dignité humaine et la vie privée, le règlement interdit les systèmes d’IA qui :

- manipulent ou trompent

- exploitent les vulnérabilités liées à l’âge, au handicap ou à la situation socio-économique

- catégorisent à l’aide de systèmes biométriques déduisant des attributs sensibles

- effectuent une évaluation sociale

- évaluent les risques de comportement criminel sur la base d’un profilage et de traits personnels

- compilent une base de données de reconnaissance faciale

- déduisent les émotions sur le lieu de travail, sauf pour des raisons médicales ou de sécurité

- identifient des personnes en temps réel grâce à l’identification biométrique à distance dans les espaces publics.

Systèmes d’IA à haut risque

Les systèmes d’IA à haut risque sont ceux qui peuvent causer un risque significatif d’atteinte à la santé, à la sécurité et aux droits fondamentaux des personnes. La réglementation définit ces systèmes comme ceux qui sont destinés à être des composants de sécurité de produits soumis à une législation européenne spécifique, y compris la sécurité de l’aviation civile. En outre, le règlement énumère les domaines spécifiques classés comme systèmes d’IA à haut risque, à savoir :

- la biométrie dans des conditions précises

- les infrastructures critiques

- l’éducation et la formation professionnelle

- le recrutement et la gestion des employés

- Accès et droit aux services privés et publics essentiels

- Application de la loi

- Gestion des migrations, de l’asile et des contrôles aux frontières

- Administration de la justice et processus démocratiques

Systèmes d’IA à risque limité et à risque minimal

Les systèmes d’IA à risque limité doivent respecter le principe de transparence. Cela signifie que les utilisateurs doivent savoir s’ils interagissent avec l’IA, par exemple lorsqu’ils utilisent des chatbots ou qu’ils sont confrontés à des deepfakes.

Les systèmes d’IA considérés comme présentant un risque minimal ne sont pas directement réglementés par la loi européenne sur l’IA et peuvent être développés tant qu’ils respectent les réglementations existantes. Les systèmes utilisés pour le développement de jeux vidéo et les filtres anti-spam sont des exemples de systèmes à risque minimal.

-

Exigences spécifiques pour chaque catégorie de risque

Toutes catégories confondues, ce sont les systèmes d’IA à haut risque qui héritent du plus grand nombre d’obligations. Il s’agit notamment de mettre en œuvre et de maintenir un système itératif de gestion des risques, qui doit être documenté parallèlement à un système de gestion de la qualité afin de garantir le maintien des règles et des procédures. Non seulement il existe un lien étroit entre la loi sur l’IA et les lois sur la confidentialité des données, par exemple à travers la nécessité de se conformer au RGPD lors du traitement des données à caractère personnel, mais la gouvernance des données a un rôle important à jouer. Pour se conformer au nouveau règlement de l’UE sur l’IA, les systèmes à haut risque doivent fournir des ensembles de données de haute qualité pour la formation, la validation et les tests. Dans certains cas, une évaluation de l’impact sur les droits fondamentaux doit être réalisée, qui peut être combinée avec l’évaluation de l’impact sur la vie privée, le cas échéant.

Avant qu’un système d’IA n’entre en service, un document technique doit être tenu à jour et démontrer la conformité du système d’IA aux autorités. En particulier, les fournisseurs de systèmes d’IA à haut risque doivent démontrer qu’ils respectent les exigences en matière de contrôle des journaux, d’exactitude, de robustesse et de cybersécurité. La transparence dans les phases de conception et de développement des systèmes d’IA à haut risque est essentielle pour permettre aux utilisateurs d’interpréter et d’utiliser correctement les résultats d’un système. En outre, la surveillance humaine pendant le fonctionnement de l’IA doit être assurée, notamment au moyen d’interfaces homme-machine.

En plus d’identifier le niveau de risque pertinent, une organisation doit comprendre son rôle précis afin d’identifier les exigences applicables. Les organisations peuvent être

- des fournisseurs : développent, mettent sur le marché de l’UE ou utilisent un système d’IA dans leur propre architecture.

- Déployeurs : intègrent un système d’IA existant dans leur propre configuration et processus.

- Importateurs : situés dans l’UE et utilisant un système d’IA provenant de l’extérieur de l’UE.

- Distributeurs : ils font partie de la chaîne d’approvisionnement (autre que le fournisseur ou l’importateur) et mettent un système d’IA à disposition sur le marché de l’UE.

-

Traitement spécifique pour l’IA à usage général

Ce sont des systèmes d’IA formés à partir de grandes quantités de données et capables d’effectuer de nombreuses tâches pour (et à travers) diverses applications. Ces systèmes visent à atteindre un niveau d’adaptabilité et de raisonnement comparable à l’intelligence humaine.

Les fournisseurs de ces systèmes d’IA bénéficient d’un régime distinct qui les oblige à se conformer à certaines exigences à haut risque, telles que l’établissement d’une documentation technique, la transparence à l’égard des utilisateurs et le respect de la directive sur le droit d’auteur.

Certaines IA à usage général peuvent présenter un risque systématique en raison de leur impact sur le marché de l’UE ou de leurs effets négatifs sur la santé publique, la sûreté, la sécurité publique, les droits fondamentaux ou la société dans son ensemble. Ces systèmes font l’objet d’une surveillance accrue, les autorités compétentes contrôlant de près leur respect d’obligations plus strictes.

-

Gouvernance, sanctions et délais

La gouvernance institutionnelle sera renforcée par la création de l’Office de l’IA, qui supervisera et contrôlera la mise en œuvre du règlement relatif aux IA à usage général. Le Conseil européen de l’intelligence artificielle, composé de représentants de chaque État membre, sera chargé de coordonner les autorités nationales et de fournir une expertise technique et réglementaire. Comme le Comité européen de la protection des données dans son propre domaine, ce comité fournira également des conseils, émettra des recommandations et des avis écrits sur des questions pertinentes liées au règlement. Au niveau national, des autorités seront désignées par chaque État membre de l’UE pour garantir et soutenir la conformité des organisations dans leurs pays respectifs.

En ce qui concerne les sanctions, la loi sur l’IA prévoit un système de pénalités échelonnées en fonction de la gravité de la non-conformité. Les amendes vont de 3 % du chiffre d’affaires global de l’entreprise ou 15 millions d’euros, jusqu’à 7 % ou 35 millions d’euros, en retenant le montant le plus élevé. À titre de comparaison, les amendes prévues par le RGPD vont de 2 % à 4 % du chiffre d’affaires mondial.

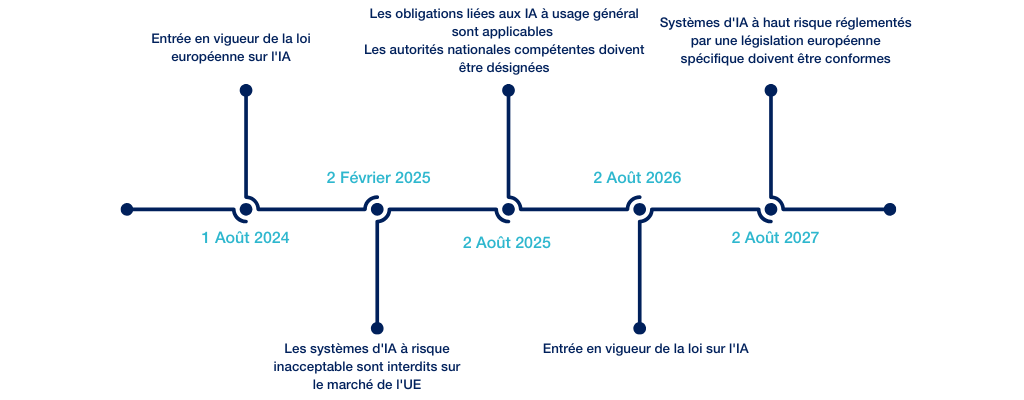

Quel est le calendrier ? À partir du 1er août 2024, le règlement sur l’IA entre en vigueur avec une application progressive, en commençant par les cas d’utilisation les plus risqués.

Le compte à rebours a commencé. Il est temps de se mettre au diapason !

- Partager